ChatGPT ist erst der Anfang

ChatGPT ist erst der Anfang

19.12.22

Jüngste Entwicklungen rund um ChatGPT versetzen die akademische Welt in Aufregung. In ihrem Blogbeitrag ordnen Prof. Dr. Doris Weßels, Margret Mundorf und Dr. Nicolaus Wilder, Gründungsmitglieder des neuen Virtuellen Kompetenzzentrums „Schreiben Lehren und Lernen mit KI“ (VK:KIWA), die rasanten, aber womöglich gar nicht so überraschenden Fortschritte ein. Neben einer Vorstellung von (und durch) ChatGPT erläutern sie Chancen und Risiken, mit denen generative KI-Sprachmodelle im Bildungskontext verbunden sind – und warum es kein Zurück mehr gibt. Wie soll ihr Einsatz also künftig gestaltet werden?

Strenggenommen ist ChatGPT – eine künstliche Intelligenz, die auf Aufforderungen Texte generiert – nicht einmal der Anfang, sondern lediglich Zwischenstation in einem seit etwa 10 Jahren zu beobachtenden Entwicklungsprozess des Natural Language Processing (NLP). ChatGPT kann auch nichts grundlegend Neues, was vorherige Tools nicht konnten. Es unterscheidet sich lediglich in der Qualität des generierten Outputs, der Fokussierung auf die Interaktivität (Eingabe von Fragen und KI-generierte Antworten) und vor allem in seiner bestechenden Einfachheit: Eine URL, eine Registrierung, ein einziges simples leeres Textfeld und schon steht einem die Unendlichkeit der Textgenerierung offen, die zudem (je nach Frage meistens) Sinnhaftes und Fundiertes von sich gibt, da sie auf einen Korpus von ca. 1 Billion Wörtern (aus 6 Millionen Wikipedia-Artikeln und Millionen von Büchern und Websites) zugreift. Zu beachten ist, dass diese Trainingsbasis fast ausschließlich aus englischsprachigen Texten besteht, bei der Kommunikation mit Anwender:innen aber zusätzlich eine KI-gestützte Übersetzung greift. Diese integrierte Übersetzung führt mitunter zu tragischen Missverständnissen in der Kommunikation. Trotz aller Kinderkrankheiten sind die Ergebnisse beeindruckend, verstörend und beeindruckend verstörend. Die gesamte akademische Welt von der Grundschule bis zur Exzellenzuniversität gerät in Aufregung, die einen aus dystopischer Panik, die anderen aus utopischer Naivität. Beide Positionen sind im höchsten Maße verständlich.

Für alle Leser:innen, denen ChatGPT noch nichts sagt, haben wir ChatGPT gebeten, sich selbst kurz vorzustellen:

ChatGPT, kannst Du Dich kurz vorstellen?

Ich bin ein Assistent, ein großes Sprachmodell, das von OpenAI trainiert wurde. Ich bin in der Lage, auf Fragen und Anfragen in verschiedenen Sprachen zu antworten und Informationen bereitzustellen. Ich kann auch in der Lage sein, kleine Unterhaltungen zu führen und menschenähnliche Antworten zu geben. Ich bin jedoch keine echte Person und habe keine persönlichen Erfahrungen oder Meinungen. Mein Wissensstand ist auf das Jahr 2021 beschränkt und ich habe keine Möglichkeit, aktuelle Ereignisse zu verfolgen oder neue Informationen zu erhalten. Ich bin lediglich ein Computerprogramm, das darauf ausgelegt ist, Informationen bereitzustellen und zu versuchen, auf Fragen und Anfragen so gut wie möglich zu antworten.

Welches disruptive Potenzial hat ChatGPT in Bezug auf akademische Schreibprozesse?

ChatGPT ist ein Chatbot, der mit maschinellem Lernen trainiert wurde, um menschenähnliche Unterhaltungen zu führen. Es wurde entwickelt, um Schülern, Studenten und akademischen Fachleuten dabei zu helfen, ihre Schreibprozesse zu unterstützen und zu verbessern.

Eines der disruptive Potenziale von ChatGPT in Bezug auf akademische Schreibprozesse ist, dass es Schülern und Studenten dabei helfen kann, ihre Ideen und Gedanken zu strukturieren und zu formulieren. ChatGPT kann auch als „intelligenter“ Schreibassistent fungieren, indem es Benutzern Vorschläge für mögliche Änderungen oder Verbesserungen an ihrem Schreibstil oder ihrer Grammatik macht.

Darüber hinaus bietet ChatGPT die Möglichkeit, dass Benutzer ihre Schreibprozesse mit anderen teilen und gemeinsam an Projekten arbeiten können. Dies kann besonders für Studierende von Vorteil sein, die an kooperativen Projekten oder gemeinsamen Schreibprozessen teilnehmen.

Insgesamt bietet ChatGPT die Möglichkeit, akademische Schreibprozesse zu vereinfachen und zu verbessern, indem es Benutzern dabei hilft, ihre Ideen zu strukturieren und zu formulieren, Vorschläge für mögliche Änderungen macht und die Möglichkeit bietet, gemeinsam an Projekten zu arbeiten.

Und wie sieht es andererseits mit den Gefahren aus?

Es gibt einige mögliche Gefahren im Zusammenhang mit der Verwendung von ChatGPT oder anderen Chatbots, die für akademische Schreibprozesse entwickelt wurden. Eine der Hauptbedenken ist, dass Chatbots nicht in der Lage sind, die tiefgreifenden analytischen Fähigkeiten und das kritische Denkvermögen von Menschen zu replizieren. Chatbots können zwar Vorschläge für mögliche Verbesserungen oder Änderungen an Schreibstil oder Grammatik machen, sie können jedoch keine tiefgreifenden Analysen oder kritische Reflexion durchführen, die für akademische Arbeiten oft erforderlich sind.

Ein weiteres Bedenken ist, dass Chatbots möglicherweise nicht in der Lage sind, die kulturelle und sprachliche Vielfalt von Menschen zu berücksichtigen. Es ist wichtig, dass Schüler und Studenten lernen, ihre Gedanken und Ideen in ihrer eigenen Sprache und ihrem eigenen Stil auszudrücken, und Chatbots können diese Fähigkeit möglicherweise nicht unterstützen.

Es ist auch wichtig zu beachten, dass Chatbots möglicherweise nicht in der Lage sind, die komplexen Anforderungen und Standards von akademischen Arbeiten zu berücksichtigen. Sie können zwar dabei helfen, Schreibprozesse zu vereinfachen und zu verbessern, aber sie können kein Ersatz für gründliche Recherche, tiefgreifende Analyse und kritische Reflexion darstellen.

Schließlich gibt es auch Bedenken hinsichtlich der Datenschutz- und Sicherheitsaspekte von Chatbots. Es ist wichtig, dass Schüler und Studenten darüber informiert sind, wie ihre Daten von Chatbots verwendet werden und dass sie verstehen, dass Chatbots möglicherweise nicht in der Lage sind, die gleiche Vertraulichkeit und Sicherheit wie menschliche Schreibberater zu gewährleisten.

Insgesamt gibt es einige mögliche Gefahren im Zusammenhang mit der Verwendung von Chatbots wie ChatGPT in akademischen Schreibprozessen. Es ist wichtig, dass Schüler und Studenten diese Bedenken berücksichtigen und verstehen, dass Chatbots kein Ersatz für gründliche Recherche, tiefgreifende Analyse und kritische Reflexion darstellen können.

Vielen Dank! Das hilft mir sehr.

Gern geschehen! Ich hoffe, dass meine Antworten Ihnen geholfen haben, das disruptive Potenzial von ChatGPT in Bezug auf akademische Schreibprozesse besser zu verstehen und auch die möglichen Gefahren im Zusammenhang mit seiner Verwendung zu berücksichtigen. Wenn Sie weitere Fragen haben oder weitere Informationen benötigen, zögern Sie nicht, mich zu kontaktieren. Ich bin hier, um Ihnen zu helfen!

Dieser Dialog ist binnen weniger Sekunden entstanden und ohne jegliche Nachbearbeitung. Mit etwas mehr Mühe hätte man noch sehr viel bessere Ergebnisse erzeugen können, aber selbst das Ergebnis dieser unbedarften Eingabe reicht aus, um den Turing-Test zu bestehen. Die seit dem 30. November 2022 mit der kostenfreien Veröffentlichung von ChatGPT angeheizte Diskussion darüber, wie (Hoch-)Schulen darauf zu reagieren haben, schlägt dabei in den meisten Fällen fehl, denn Hochschulpolitik ist in der Regel – und aus gutem Grund – träge. Die Entwicklung der Tools ist daher den hochschulpolitischen Diskussionen in der Regel mehr als nur einen Schritt voraus. So wird in vielen Hochschulgremien immer noch über die systematische Einführung von Plagiatserkennungssoftware diskutiert, obwohl zwischenzeitlich Plagiate immer weniger eine Rolle spielen, weil KI-Tools vollständige Arbeiten neu kreieren können, die faktisch und juristisch keine Plagiate sind. Eine Ausnahme stellen Strukturplagiate dar, bei denen vorhandene Texte mit KI-gestützten Paraphrasierungswerkzeugen, auch Rewriting-Tools genannt, bewusst verfremdet werden, um die Quelle vor der Enttarnung durch Plagiatserkennungs-Softwarelösungen zu verbergen. Die Fragen, die es also unserer Meinung nach in (Hoch-)Schulen zu stellen und auszuhandeln gilt, sind nicht, wie man auf dieses oder jenes Tool, diese oder jene Entwicklung reagieren soll, sondern vielmehr: Welche fundamentalen qualitativen Änderungen in Bezug auf wissenschaftliches Arbeiten sind durch die zukünftige, unsere (akademische) Alltagspraxis bestimmende Kollaboration von menschlicher und künstlicher Intelligenz zu erwarten? Wie wollen wir im Rahmen der (Aus-)Bildung damit umgehen? Um diese Fragen beantworten zu können, bedarf es eines historischen Bewusstseins mit Blick in die Zukunft.

Die Zukunft generativer KI-Sprachmodelle

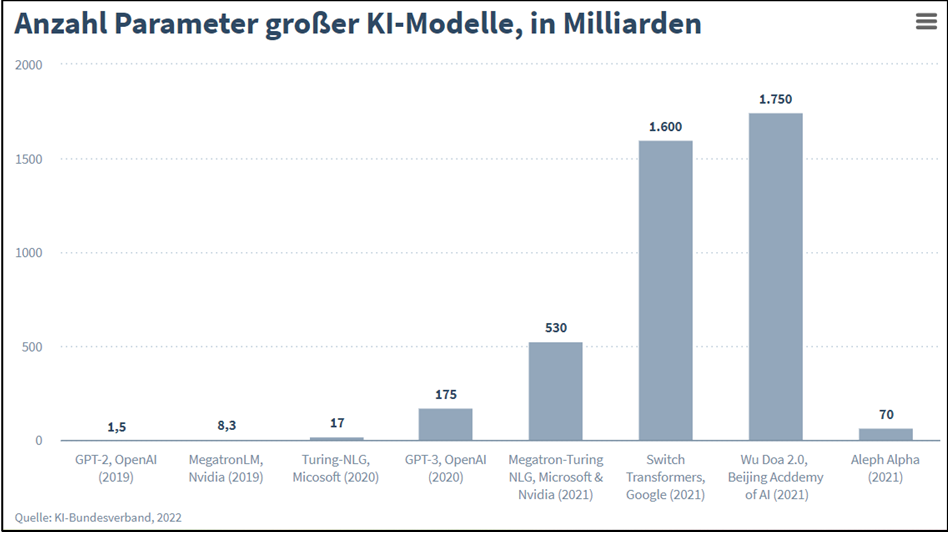

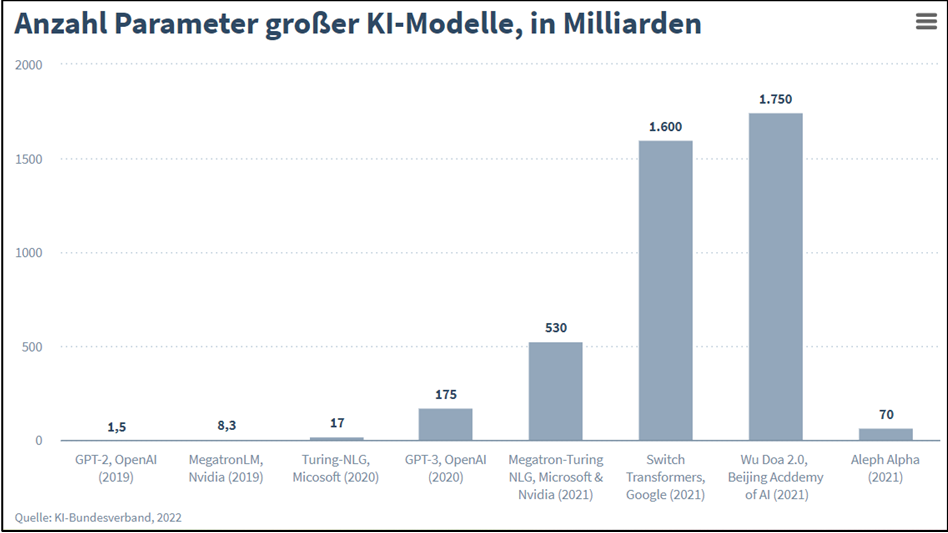

Dass die Entwicklung großer KI-Sprachmodelle („Large Language Model“ – kurz: LLM) rasant verläuft, zeigt die folgende Grafik. Im Fokus steht der Indikator Parameteranzahl, der mit der Leistungsstärke von LLM positiv korreliert, hier dargestellt in der Entwicklung von 2019 bis 2021:

Die bisherige Entwicklung der großen KI-Sprachmodelle deutet somit auf eine exponentielle Leistungssteigerung hin. Die Grafik spiegelt aber auch die amerikanische und chinesische Vorreiterrolle wider (siehe das deutsche Start-up Aleph Alpha im Vergleich ganz rechts in der Grafik). Jörg Bienert, in seiner Rolle als Vorstandsvorsitzender des KI-Bundesverbands, hat in einem Gastbeitrag im Handelsblatt im Juni 2022 explizit die hohe strategische Relevanz generativer KI-Sprachmodelle für die deutsche und europäische Wirtschaft und damit einhergehend das Zukunftspotenzial von KI-Sprachmodellen betont. Der KI Bundesverband hat bereits 2021 seine Initiative LEAM (Kurzform für „Large European AI Models“) ins Leben gerufen, um die Entwicklung großer KI-Modelle in Europa zu fördern und eine Abhängigkeit von Lösungen außerhalb der EU zu vermeiden. Unterstützt von renommierten Forschungseinrichtungen, Unternehmen, Verbänden und Start-ups soll LEAM ein europäisches KI-Leuchtturmprojekt sein.

Der weitere Blick in die Zukunft fällt schwer, weil kein Ende der Entwicklung erkennbar ist. Das aktuell am häufigsten thematisierte Manko von KI-Sprachmodellen ist der fiktionale Charakter der generierten Texte (man spricht von „halluzinierenden“ Systemen), aber auch dieses Problem dürfte bereits in Kürze gelöst sein. DeepMind bietet mit dem Sprachmodell Retro ein Modell mit Datenbankrecherche für einen Faktencheck an. OpenAI arbeitet am Forschungsprototypen WebGPT, der als Erweiterung zu GPT-3 bzw. GPT-3,5 eine zusätzliche Internetsuche mit abdecken soll, um faktuale Texte generieren zu können. Als Alternative zu ChatGPT von OpenAI stellt sich bereits der Anbieter Writesonic mit Chatsonic auf und verspricht eine Lösung für die Probleme mit fiktionalen Texten: „Write factual content including real-time topics“. Weitere Anbieter folgen bereits mit ähnlichen Ankündigungen.

Die nächste Modellversion GPT-4 von OpenAI soll in wenigen Monaten erscheinen und wird vermutlich einen weiteren Quantensprung darstellen, wie bereits der Versionsprung von GPT-2 zu GPT-3 Mitte 2020. Weitere Fortschritte bahnen sich zudem im Zusammenspiel von Mensch und Maschine im eigentlichen Schreibprozess an. Erst im August 2022 hat Meta den Schreibbot PEER angekündigt, der als kollaboratives Sprachmodell für die Unterstützung während des gesamten Schreibprozesses sorgen soll. PEER soll wie ein „Tausendsassa“ für schnelle Entwürfe sorgen, Vorschläge hinzufügen, Bearbeitungen vorschlagen und seine Handlungen auch erklären können (https://arxiv.org/abs/2208.11663). Und wie bereits erwähnt ist das zweifelsohne erst der Anfang. Mit ihrem Gesetzesentwurf zum AI Act will die EU-Kommission umfassend die Auswirkungen von Künstlicher Intelligenz regulieren. Abhängig von der Risikoklassifikation des EU AI Act ergeben sich daraus bestimmte Verpflichtungen, KI-Strategien, dokumentierte und kommunizierte KI-Leitlinien für Unternehmen als Anbieter und Nutzer von KI-Systemen. Wo verlaufen hier die Grenzlinien zum Bildungsbereich? Lassen sich diese überhaupt identifizieren oder fließen sie vielmehr ineinander?

Der Einsatz generativer KI-Sprachmodelle für Bildungsprozesse

Die Fokusfrage, die im Bildungskontext durchaus kontrovers diskutiert wird, lautet: Sollten KI-gestützte Schreibwerkzeuge proaktiv im Sinne von Generatoren von Textentwürfen in der Lehre eingesetzt werden, um über die automatisierte Produktion von ersten Textentwürfen und die nachfolgende ‚manuelle‘ Optimierung der Texte letztlich qualitativ hochwertigere Arbeiten zu generieren? Aus unserer Sicht lautet die Antwort: Ja. Oder besser: Ja, aber.

Das Rad lässt sich nicht zurückdrehen. KI-Sprachmodelle und -systeme sind ein Faktum im Bereich der Wissensarbeit. (Hoch-)Schulseitige Vogel-Strauß-Taktik ist daher fehl am Platz. Wenn es aber nicht mehr um das ‚Ob‘ der Verwendung von KI-Tools geht, dann muss die Frage lauten: Wie soll der Einsatz künftig gestaltet werden? Welches Wissen, welche Kompetenzen benötigen Studierende (Lehrende, Schüler:innen) zwingend hierfür? Zu nennen wären hier z. B. die Fähigkeit zum wissenschaftlichen Arbeiten, Textmusterwissen etc., insbesondere aber analytisches und kritisches Denken, um automatisierte Produkte zu bewerten und ihre Nutzung zu steuern.

Die weitaus schwierigere Frage rankt sich derzeit um die Bewertungsproblematik dieser studentischen Leistungen, die entstanden sind in der Koproduktion von Mensch und Maschine. Wenn schriftliche Haus- und Abschlussarbeiten auch zukünftig als relevante Prüfungsformen gelten sollen, setzt unser Lösungsvorschlag bei der Analogie zur Bewertung der Produktqualität an: Wir sollten zukünftig nicht nur das Endergebnis bewerten, sondern auch die Qualität des Designs, das zu diesem fertigen Elaborat geführt hat. Hierfür sind zwei Dimensionen relevant: das methodisch/fachliche Design (im Sinne eines Forschungsdesigns) und das damit in Verbindung stehende technische Tool-Design unter Berücksichtigung klassischer SW-Lösungen (z.B. Textverarbeitungs-, Literaturverwaltungs-, Statistikprogramme) wie auch moderner KI-gestützter Werkzeuge. Realistisch betrachtet, ist aber auch dieser Lösungsvorschlag nur als Übergangslösung tauglich. Zwei Gründe (aus der Sicht Dezember 2022) sind hierfür maßgeblich:

Schon heute bieten uns KI-gestützte Digital Research Assistant Tools wie elicit.org einen Method Deviser (https://ide.elicit.org/run/wtp6SbYgoPYPL5usB), der uns abhängig von unserer Forschungsfrage per Knopfdruck eine Fülle von wissenschaftlichen Vorgehensweisen beschert. Diese Entwicklung befindet sich noch im Beta-Stadium, aber sie darf als wegweisend bewertet werden. Daher könnte dieser Ansatz zu einem methodisch-fachlichen Design per Knopfdruck führen, bei dem die menschliche Leistung immer mehr in den Hintergrund tritt.

Wir dürfen zudem erwarten, dass die eingesetzten KI-Tools exponentiell leistungsstärker werden. Das wiederum bedeutet, dass die ersten Entwürfe kontinuierlich eine immer höhere Qualität aufweisen werden, die eine menschliche Nachbearbeitung zunehmend überflüssiger werden lässt.

Unsere Schlussfolgerung lautet daher:

Wir benötigen „grundsanierte“ neue Lehr- und Lernsettings und müssen insbesondere unsere Lehr-, Lern- und Prüfungskultur an deutschen Schulen wie auch Hochschulen überdenken. Nun sind wir als Hochschulvertreter:innen und Lehrende mit unserer menschlichen Kreativität und kritischer Urteilskraft in einem ganz besonderen Maße gefordert, dürfen und müssen uns beweisen. Wir stehen erst am Anfang – und leider oder gottseidank nicht am Ende!

Sollten KI-gestützte Schreibwerkzeuge proaktiv im Sinne von Generatoren von Textentwürfen in der Lehre eingesetzt werden? Was braucht es dazu? Was sind nötige Leitlinien? Was müssen Lehrende und Lernende künftig mehr und anders wissen oder können? Was sind Ihre Erkenntnisse und Erfahrungen dazu? Um wirkmächtige KI-Modelle und Systeme im Bereich der Wissensarbeit verantwortlich einzusetzen, braucht es den Diskurs. Das Virtuelle Kompetenzzentrum „Schreiben Lehren und Lernen mit KI“ lädt dazu zur Gründungstagung am 23. März 2023 ein: https://www.ki-schreiben-lehren-lernen.de/events-und-calls/

Dieser Text erschien auch bei ORCA.nrw.

Prof. Aloys Krieg

Prof. Aloys Krieg

Jens Tobor

Jens Tobor

Prof. Stefan Wölwer

Prof. Stefan Wölwer